Release notes 2021

2021 updates on any recent changes, feature enhancements, or bug fixes for the Digibee iPaaS.

Release Notes 12-21-2021

COMPONENTS

Email V2: we’ve added a new parameter to the component: FORCE TLS V1.2. It allows users to set the use of the protocol TLS V1.2 as mandatory for connections with email servers. Important: we recommend the use of this parameter with Microsoft Exchange email servers. Click here to read the full article on the component.

We’ve also fixed a few bugs:

Scheduler Trigger: we’ve fixed an error that, on rare occasions, prevented the execution of consecutive scheduled tasks.

Release Notes 12-14-2021

NEW ACCESS CONTROL MODEL

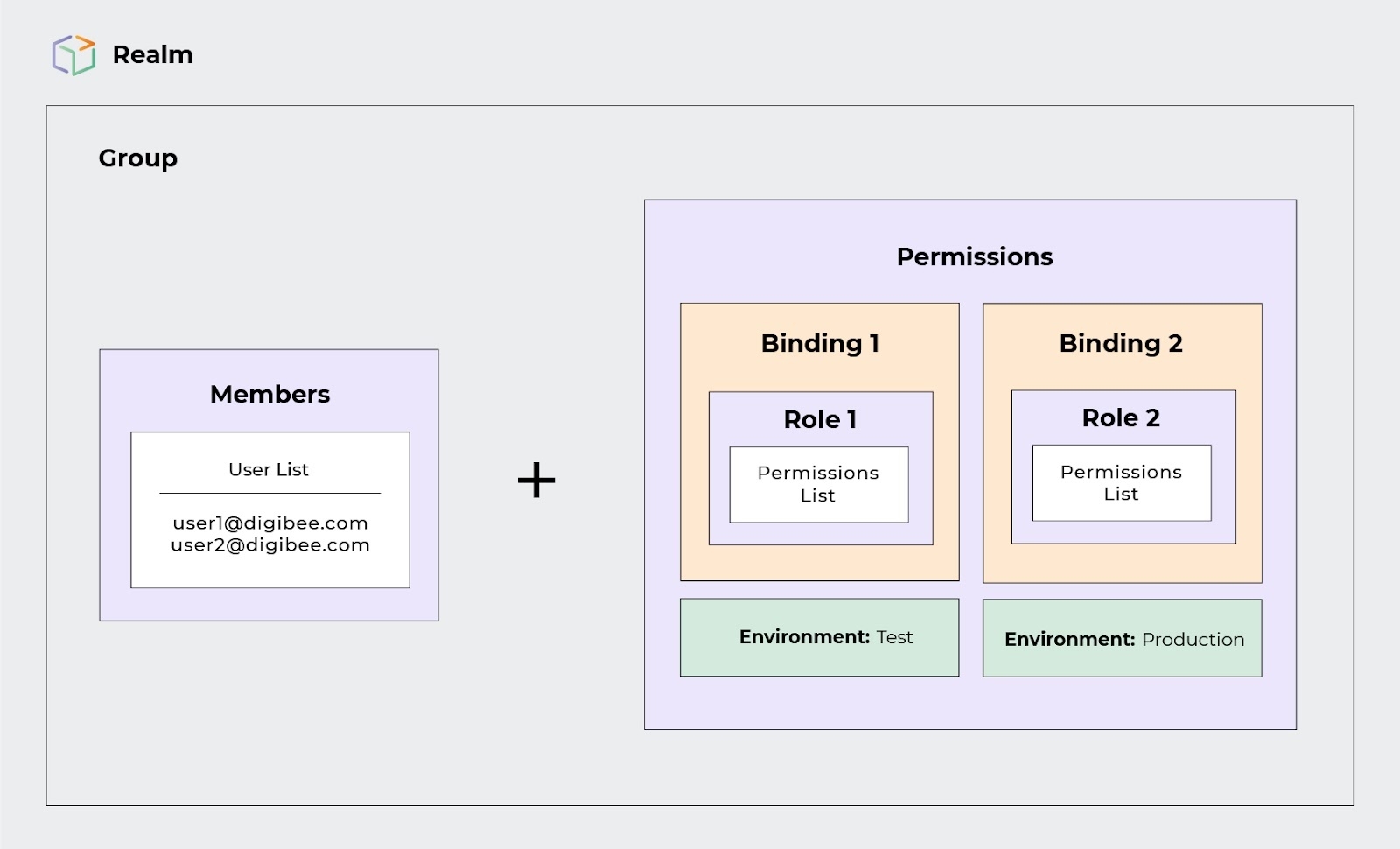

We’ve developed a new access control model. It’s practical and robust. The access management now allows grouping and reusing the profiles with similar accesses for a better experience when accessing the realm.\

Example of the new access grant:

The new access control model includes the concepts of Groups, Roles and Users that are related to one another just like on the model below:

Now, updates in a user’s access will be in real time. There’s no need to logout for the update.

To learn more about the new access control, read the following articles:

New Access Control Model

Access Control Groups

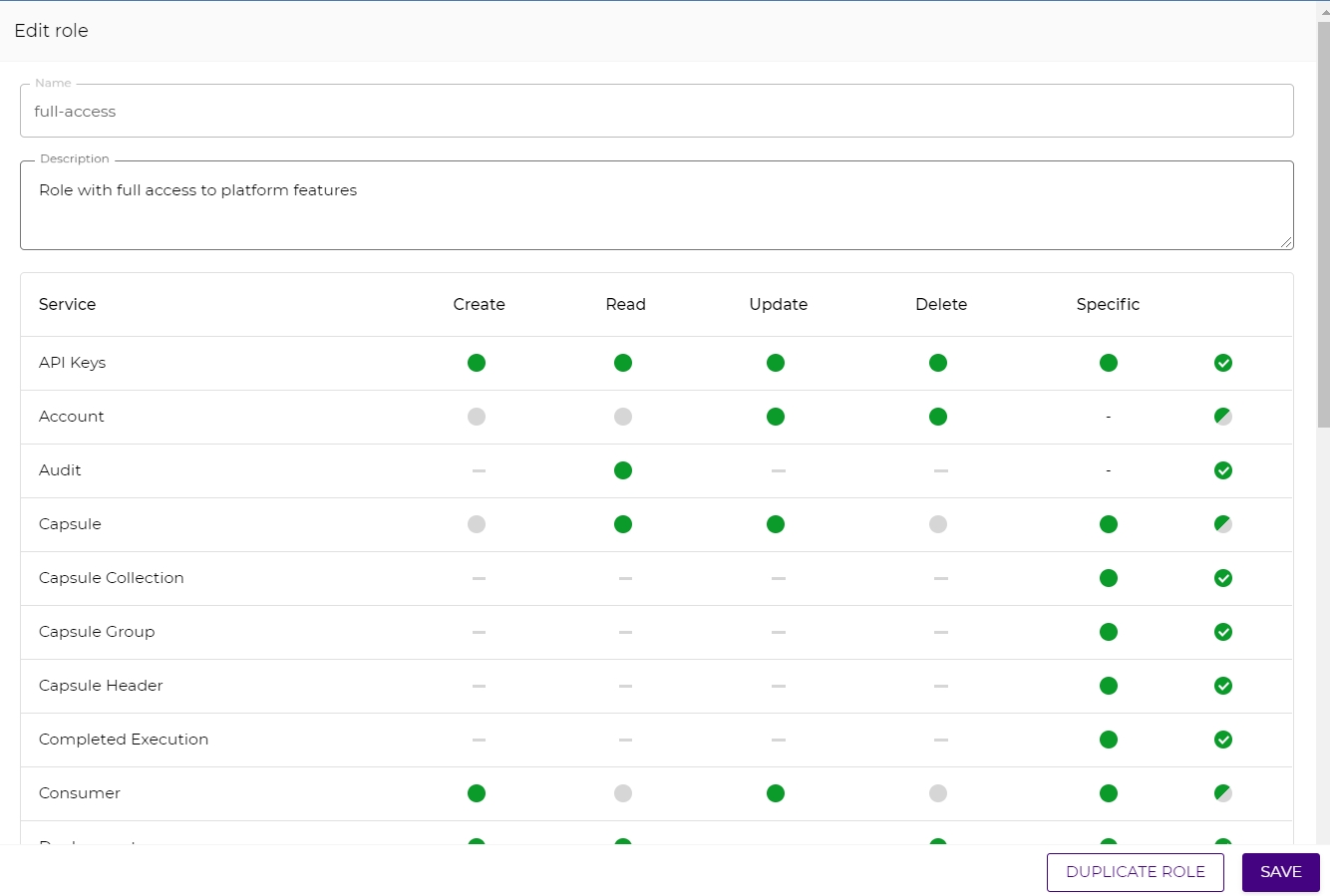

Access Control Roles

Basic Concepts About Users

Just so no users lose their permissions, we planned a transition period in which both access models will coexist. All users must be migrated to the new access until March 31, 2022. To learn more about the transition process, read the full article here.

CONSUMERS SCREEN - RENAMED TO API KEYS

Thinking about improving our users’ experience and giving them more clarity and accuracy on the use of a few terms, we’ve updated the Consumers screen under the Settings menu. Its new name is API Keys. The functionalities have not changed and the settings flow is still the same as well.

AUDIT

We’ve made some improvements on the audit experience. Now, the audit logs contain new information:

Service - identification of the Digibee Integration Platform’s features that have been audited. E.G.: Pipelines, Globals, Accounts.

Action - the action taken that created the register. E.G.: created, updated, deleted, viewed.

Reference - it’s the friendly name of the audited object.

IMPORTANT: During this delivery phase, the only objects with the reference are: Pipeline, Account and Globals.

Status: shows if the action has been successful or if it contains any error.

This delivery is part of a larger improvement process that will include the possibility of navigating up until the audited object.

COMPONENTS

XML Schema Validator: the client is now able to validate a XML file against XSD files. Click here to read the full article.

We’ve also fixed a few bugs:

Component CSV to Excee’ve fixed the error that prevented the ability of reading files with charsets different from UTF-8.

Pipelines Metrics: we’ve fixed the error that prevented the correct exhibition of information when filtered with the 15 minutes period option.

Email Trigger V2: we’ve fixed the error that prevented new emails from being read, moved and deleted correctly after they had been processed.

Release Notes 11-30-2021

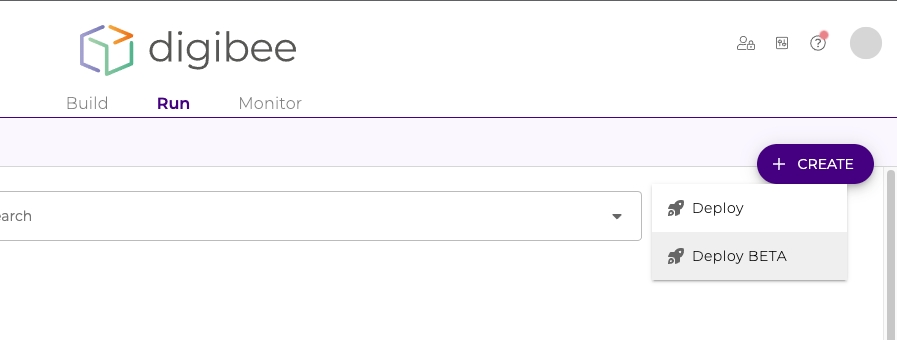

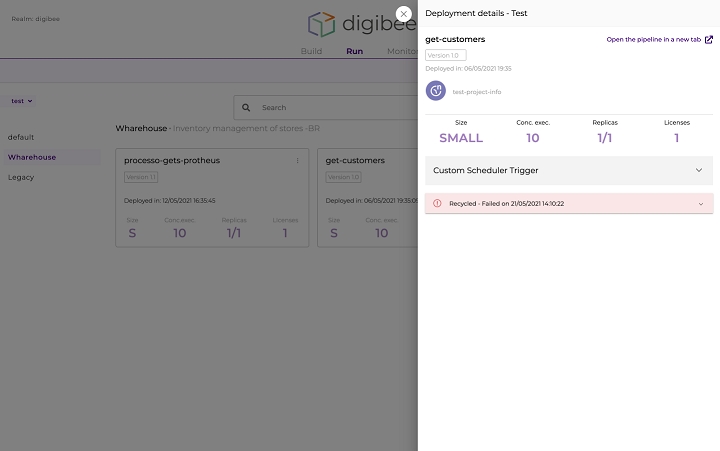

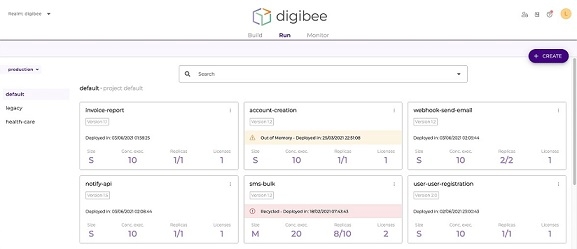

NEW DEPLOYMENT EXPERIENCE (Beta)

We have developed a new experience for your pipelines’ deployment.

The new deployment screen offers more autonomy and ease, bringing more data to help the decision making process at the moment of the pipelines’ deployment, such as the indication of who has deployed them. Click here to read the full article about the new interface.

IMPORTANT: During the period of the Beta program, the functionality will be offered parallel to the current one - this way you will see two buttons on the screen.

To read more about the Beta program, access our document here.

HISTORY OF PIPELINES' VERSIONS (Beta)

We added a new functionality to the history of pipelines’ versions. Now it’s possible to see any minor version of a pipeline, its components and the settings of each of them. Click here to read the full article about the pipeline history .

To read more about the Beta program, access our document here.

PROJECTS

We added an improvement to the Projects management. When a pipeline is moved to a new project, it’s necessary to deploy it again because the execution environment of pipelines (Test and Prod) are unchangeable. This way, there will be an alert on the deployments in need of this action.

IMPORTANT: this functionality doesn’t support multi-instance deployments yet.

LOGIN

Aiming to improve security when accessing the Platform, your login’s password will expire every 15 days.

From now on it will be necessary to create a new password every 15 days and login again to reestablish your session.

In case there is any need to change the password’s expiration period, get in touch with our support team through the chat. Only the realm’s administrator can make the request.\

ACCOUNTS WITH OAUTH

We updated the documentation of the article on Accounts and we added the expiration period of the tokens given by the following providers:

Microsoft - 3 months Google - 6 months Mercado Livre - 6 months

Click here to read the full article.

COMPONENTS

Rest V2: we updated the documentation of the component. Click here to read the full article.

Release Notes 11-02-2021

CHAT

In order to always offer you support, we built an alternative messaging feature. Now, it’s possible to send questions and requests to our support team even if our online chat is unavailable. The answers will be sent by email.

OAuth 2.0

Due to updates in the OAuth server from Mercado Livre, we have modified the OAuth provider from Mercado Livre so that it authenticates through the endpoint of accounts from Brazil (www.mercadolivre.com.br/authorization). IMPORTANT: the current tokens registered in Accounts won’t be affected. New tokens will be obtained through the new endpoint.

COMPONENTS

Google IAP Token

The new component enables you to generate OpenID-type tokens for IAP (Identity Aware Proxy) proxies authentication. Click here to read the full article.

SQS (AWS)

The new SQS component enables you to send messages to FIFO-type queues in AWS SQS service. Click here to read the full article.

FUNCTIONS

CARDINALITYONE

The function allows a cardinality of n:1 to be applied to any informed structure, where regardless of the number of elements in the input, the output will always be 1 element. Click here to read the full article on JSON Functions.

CARDINALITYMANY

The function allows an output to be standardized by a multiple cardinality. That means, when an input of an array has n elements, its output will be an array of n elements, and when an input has a sole object, its output will be an array of this same object. Click here to read the full article on JSON Functions.

We’ve also fixed a few bugs:

LDAP Component: We fixed a bug that blocked pipelines from executing when using the LDAP component.

Chat: We removed the requirement of the USER:READ permission for a user to access the chat.

Pipeline history: We fixed the bug that resulted in a white screen when all versions of a pipeline were archived, and when one of the versions was restored.

Release Notes 10-19-2021

COMPONENT

NFS: The component manipulates files. It lists files, and enables downloading, uploading, and deleting. Click here to read the full article.

IMPORTANT: due to the characteristics of the NFS protocol, only Dedicated SaaS platforms are supported.

We’ve also fixed a bug:

Environment selector in Monitor: we fixed a bug that did not save the last environment selected after switching screens.

PUSH: now it’s possible to use the PUSH(array, element) function to insert new elements at the end of an array in order to implement a stack structure. Click here to read the article about PUSH and the other JSON functions. \

POP: now it’s possible to use the POP(array) function to remove the last element of an array in order to implement a stack structure. Click here to read the article about POP and the other JSON functions.\

FUNCTIONS { {DOUBLE BRACES} }

Trigger HTTP/REST: now the Triggers REST, HTTP, and HTTP File add the invoked path as part of the request information from a pipeline. You can read the articles about each trigger in the following links: REST Trigger HTTP Trigger HTTP File Trigger

TRIGGERS

digibeectl is an application that not only exposes commands for your pipelines management, but also enables interactions with its respective deployments at each stage in the Digibee Integration Platform. Click here to know more about digibeectl. IMPORTANT: You can request access to the restricted beta program of digibeectl through our chat or with the Customer Success team. If you want to know more about the Beta program click here.

Release Notes 09-28-2021

digibeectl - restricted beta

digibeectl is an application that not only exposes commands for your pipelines management, but also enables interactions with its respective deployments at each stage in the Digibee Integration Platform. Click here to know more about digibeectl. IMPORTANT: You can request access to the restricted beta program of digibeectl through our chat or with the Customer Success team. If you want to know more about the Beta program click here.

TRIGGERS

Trigger HTTP/REST: now the Triggers REST, HTTP, and HTTP File add the invoked path as part of the request information from a pipeline. You can read the articles about each trigger in the following links: REST Trigger HTTP Trigger HTTP File Trigger

FUNCTIONS { {DOUBLE BRACES} }

PUSH: now it’s possible to use the PUSH(array, element) function to insert new elements at the end of an array in order to implement a stack structure. Click here to read the article about PUSH and the other JSON functions.

POP: now it’s possible to use the POP(array) function to remove the last element of an array in order to implement a stack structure. Click here to read the article about POP and the other JSON functions.

Release Notes 09-10-2021

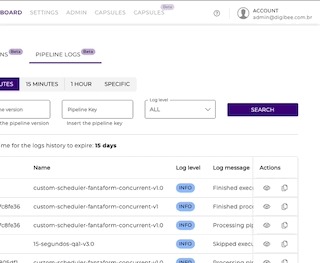

PIPELINE LOGS SCREEN

We’ve made an improvement to the delay in displaying pipeline logs. This improvement is part of a bigger plan to enhance the performance of log collection. We’ve also fixed a few bugs:

Empty pipelines list: we’ve fixed an error in the create pipeline button that had no action associated.

Empty implementation list: we've fixed the update button label under Run.

Release Notes 08-31-2021

COMPONENTS

Hash

We’ve added the BCrypt algorithm to the Hash component. To read its updated article, click here.\

NEW LAYOUT

We recently communicated the automatic switch to our new layout. When making your login, you’ll be forwarded to the Platform with an aesthetic consistent with the integration building cycle, based on Build, Run and Monitor.

But don’t worry…

this change won’t affect your experience at all

we’ll keep receiving your comments about the new layout through the feedback channel

Projects: we’ve corrected an issue that wouldn’t allow pipelines to be moved to projects with special characters in their titles. Besides, existing pipelines in the projects wouldn’t be displayed in the Run screen.

Monitor and Build: we’ve made adjustments to improve the upload of pipeline listings and dashboard in the Monitor and Build screens.

Audit: we’ve fixed the bug that wouldn’t allow the access menu to be viewed in the new Platform layout.

Digibee Storage: we’ve fixed the problem that would generate an incorrect link for download when uploading a file to a directory starting with the “ / “ character.

Release Notes 08-17-2021

COMPONENT

Digibee JWT

The component that was already available in our palette, and that used to be named JWT, now is called Digibee JWT. It’s been specifically designed for authentications that use the Digibee gateway and its functions haven’t changed.\

JWT

The new JWT component is now available, generating and decoding JWT tokens for external use. With that, you can manipulate JSW or JWE tokens according to your cryptography, signature and dynamic payload needs.

Note: to better understand the difference between the 2 components, click on the titles below and access the updated documentation of each one:

Digibee JWT (internal use) JWT (external use) \

FUNCTIONS (DOUBLE BRACES)

REMOVEAT

Now it’s possible to use the function REMOVEAT (array, index) to remove specific elements of an array in a JSON. Click here to access the article about REMOVEAT and other JSON functions.

RUN

We’ve added a new pipeline validations that allows you to check if the configured trigger needs a dedicated configuration for the realm environment.

NEW LAYOUT

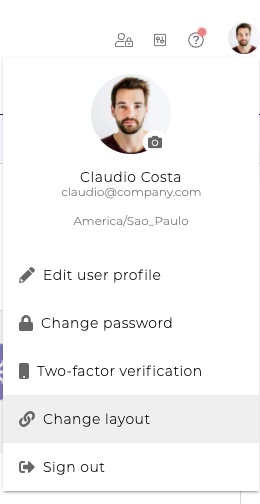

We’re automatically enabling our new layout. From now on, when making your login, you’ll be forwarded to the Platform with an aesthetic consistent with the integration building cycle, based on Build, Run and Monitor.\

But don’t worry…

this change won’t affect your experience at all

you have until August 30th 2021 to use the former layout - all you have to do is click on your profile icon to select it

we’ll keep receiving your comments about the new layout through the feedback channel.

Digibee Storage: we’ve fixed the problem that would generate an incorrect link for download when uploading a file to a directory starting with the “ / “ character.

Release Notes 08-03-2021

COMPONENTS

SOAP V2

We’ve added a new functionality to the component, which allows a determined request answer to be recorded in the pipeline local file. Click here to read the complete article about SOAP V2.

Kafka

Now it’s possible to inform the topic partition to which you'd like to send a message to Kafka. To read the updated article about the component, click here.

DB V2

CLOB-type data can now be sent through a file. You can read the updated article about the component by clicking here.

TRIGGERS

Kafka

Now it’s possible to inform the topic partitions to consume the Kafka messages. To read the updated article about the trigger, click here.

FUNCTIONS

ESCAPE/UNESCAPE

The ESCAPE and UNESCAPE functions now allow the escape type in JSON, CSV, html and xml patterns to be informed. To read about these and other string functions, click here.

SIZE

We’ve added a new parameter to the SIZE function. With it, it’s possible to determine if an exception must be thrown (true) or not (false) when something goes wrong in the verification of an object size, array or JSON. You can read the article about SIZE and other utilities functions by clicking here.\

PROJECTS (BETA)

By standard, all the current Projects are visible to every user. But now, on top of creating and editing Projects, you can also grant visibility permissions by user. With such improvement, your Projects can be visualized by specific users.

We’ve also fixed a few bugs:

Major pipeline versions by Project (Beta): we’ve adjusted an error that would allow the display of all the pipeline versions even when a specific major version was moved to another Project.

Deployment: we’ve corrected an issue that wouldn’t allow new deployments to be created when all the existing deployments in a realm were removed.

Release Notes 07-20-202

DOCUMENTATION

We’ve updated the reading about a component so you can have a better experience with your integrations.

You can access the following reviewed articles:

COMPONENTS

DB V2

We’ve had improvements in the DB V2 component to enable custom data types (STRUCT) receival via procedures in Oracle databases. Click here to access the updated article about DB V2.

Mongo DB

Now you can configure connection properties (eg.: timeout) in the Mongo DB component. Click here to read the article.\

We’ve also fixed a few bugs:

CSV to JSON V2

It became possible to specify the charset of the file to be read by the CSV to JSON V2 component.

Portal adjustments

reduction in the time to save pipelines;

pipelines with many versions no longer present error when saved;

improvement in the responsiveness of pipelines and deployments listing;

correction in the pipeline re-execution screen, which wouldn’t let the request to be sent;

improvement in the display of information about adjustments in the Capsules deployment;

the list of names of pipelines moved between projects is now fully displayed.

PUBLIC CAPSULES

Thinking about making your routine with the Digibee Integration Platform easier, we’re releasing ready-to-use Capsules.

Take a look at the Collections with news:

SAP

The SAP Collection Capsules have all been designed to abstract calls to SAP, encapsulating the capacity of calling remote functions (RFC) to the SAP system and delivering flexibility and easiness to integrate other systems with SAP.

SAP RFC - Connector (JSON Input): generic Capsule, used for any operation with the SAP remote functions. It’s possible to read table data and registers in a more complete way, update or insert new registers (suppliers, clients, addresses, etc.).

SAP RFC - Read Nota Fiscal: obtains invoice information through the BAPI_J_1B_NF_GETDETAIL function.

SAP RFC - Connectivity test: Capsule for connectivity tests with SAP.

SAP RFC - Read Table: check SAP table data through the RFC READ_TABLE function.

Click here to read the complete article about this Collection.

Release Notes 07-06-2021

TERM OF USE

We’ve updated our Term of Use, which will be activated on July 8th 2021 at 11 AM (New York time, GMT-04). To guarantee your individual Platform use, login, carefully read the content and select the option “I agree with the Term described above”.

DOCUMENTATION

We’ve updated the reading about some components so you can have a better experience with your integrations.

You can access the following new articles:

CONSUMERS CONFIGURATION

We’ve made improvements in the interface of pipelines association to a consumer, assuring better performance in the pipelines list loading.

SESSION EXPIRATION

Due to security matters, your Platform session will expire every 60 days, whether there’s activity or not.

USABILITY IMPROVEMENTS

We’re constantly working to improve your experience in the Platform. This is what we’ve delivered:

we’ve added information about the configurations used in the pipelines trigger;

we’ve inserted the occurrence date of the last pipeline error.

Collections: we’ve eliminated an error that would allow Collections, Groups and Capsules to be displayed even after being archived. Now these items are displayed only when active.

Release Notes 06-22-2021

We’d like to share some improvements and news:\

USABILITY IMPROVEMENTS

We’re constantly working to improve your experience in the Platform. This is what we’ve delivered:

we’ve added a new component of loading preview.

COMPONENTS

DBs

Now the components DB V2 and Stream DB V3 can make inquiries that handle the CLOB type as a file. Click on the components title to access the updated documentation.

Kafka

Now it’s possible to inform a truststore that has a reliable certificate chain and/or a keystore that has the certificate chain and the private key from the client side to publish in the Kafka topics. To access the updated article about the component, click here.

TRIGGERS

Kafka

Now it’s possible to inform a trustore that has a reliable certificate chain and/or a keystore that has the certificate chain and the private key from the client side to consume in the Kafka topics. To access the updated article about the trigger, click here.

DOCUMENTATION

We’ve updated the reading about some components so you can have a better experience with your integrations.

You can access the following new articles:

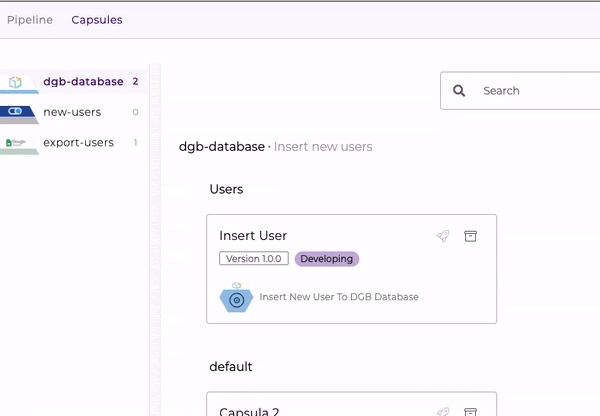

CAPSULES

Now you can:

edit group names;

delete groups;

create a Capsule from an existing group.

The functionality above requires specific permissions that your user might still not have. If necessary, get in touch with your Real administrator.

ORACLE

Now it’s possible to receive custom Oracle types in queries that use the DB V2 and Stream DB V3 components.

We’ve also fixed a bug:

Stream DB V3: we’ve fixed the bug that would interrupt the execution of a pipeline with error when a nule BLOB was received.

Release Notes 06-08-2021

We’d like to share some improvements and news:

NEW LAYOUT AND PROJECTS BETA

The new Run screen is also available under our new layout.

Click here to access the updated article about the new layout.

DOCUMENTATION

We’ve updated the reading about a component so you can have a better experience with your integrations.

You can access the new article about Assert by clicking here.

Release Notes 05-25-2021

We’d like to share some improvements and news:

NEW LAYOUT AND PROJECTS BETA

We’re releasing the beta version of our new layout and of the Projects functionality. For you to get the most out of what these news have to offer, we’ve created articles that clarify:

what the new layout brings and how to enable it

what the Projects functionality is, how it works, how to enable it and the step-by-step of its use

Click here to access the article about the new layout.

Click here to access the article about the Projects functionality.

COMPONENTS

Stream XML File Reader: we’ve created a new component that allows large XML structures enabled in files to be run item by item, with filters and in an efficient way in terms of memory use. Click here to access the article about Stream XML File Reader.

Object Store: we’ve inserted in the Object Store documentation an explanation about the UPSERT operation inside a loop component when the parallel execution option is enabled. Click here to read the updated article.

RUNTIME

Pipelines validation: we’ve improved your experience with the Platform by providing more feedback during the deployment, saving time and avoiding consecutive deployments due to minor errors.

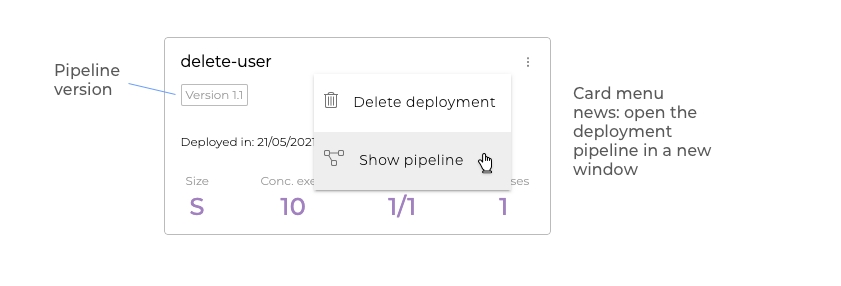

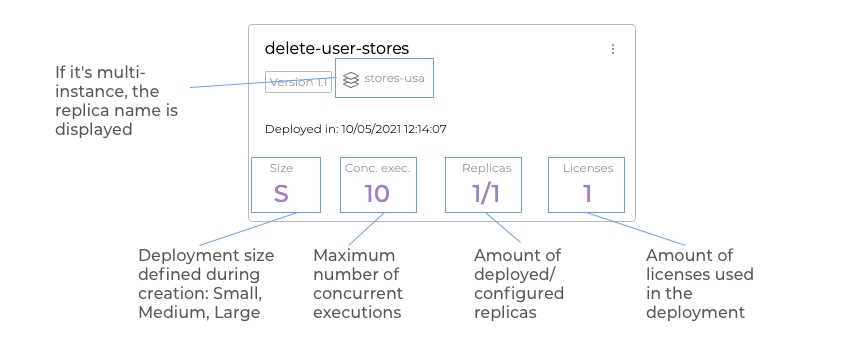

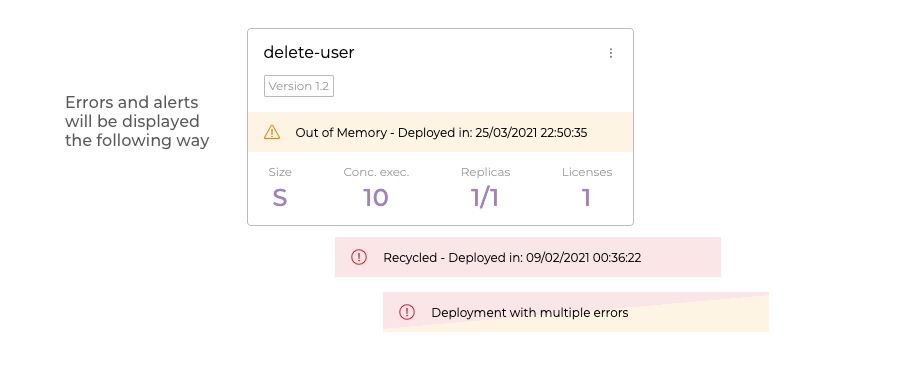

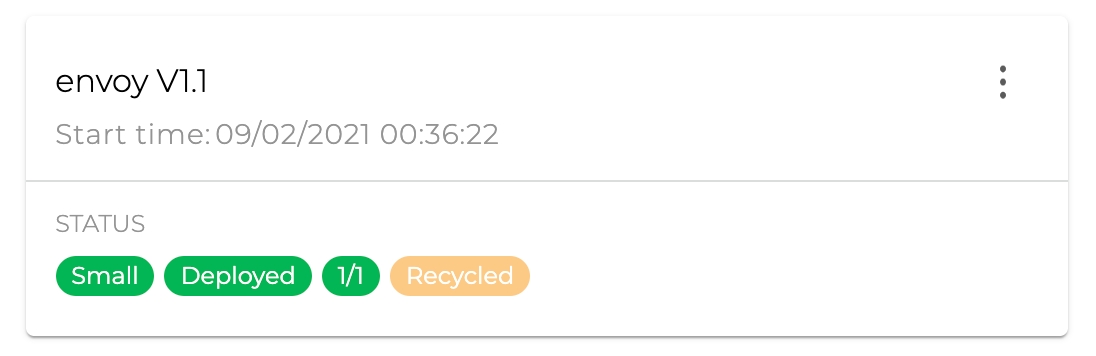

Visual change: now it became even easier for you to understand the deployments status. Take a look at the cards visual appearance:

Runtime and configurations: we’ve fixed the bug that wouldn’t let confirmation or error messages to be displayed in creation, delete or edition processes in configurations or deployments.

REST V2: we’ve solved the problem that wouldn’t allow the use of Custom Accounts in the configuration of a call with multipart/form-data and Double Braces.

S3 Storage: we’ve adjusted the Link Expiration (in ms) parameter name to Expiration Timestamp (in ms) and, with that, it’s easier for you to understand how to make the parameter correct configuration. To better understand this difference, access the updated article of S3 Storage by clicking here.

PUBLIC CAPSULES

Thinking about making your routine with the Digibee Integration Platform easier, we’re releasing ready-to-use Capsules.

Take a look at the Collections with news:

Digibee Tools

This Capsule brings tools that help to standardize your pipeline through the best practices, such as agility, validations quality and ready transformations.

CPF CNPJ Validator: enables the verifying digit of Brazilian documents related to people register to be validated.

Digibee Publish Error: sends notifications of standardized messages for alerts and errors handling to be more clear and efficient.

Parallel Execution List to Objects: transforms arrays of objects produced by parallel executions. This Capsule is highly useful when combined with the Parallel Execution component.

Sort Array by field: orders lists in JSON format from a determined field.

Validate Consumers: validates the amount of configured consumers according to the pipeline Runtime.

Click here to read the complete article about this Collection.

Digibee News

Have access to the new layout and Projects!

Did you know that from May 25th 2021 you’ll have access to the beta version of our new layout and to the Projects functionality?

New layout

The new Digibee Integration Platform layout is the first step of the revolution we’re promoting in our interface. The idea is for you to enjoy a more objective navigation, with a more pleasant, friendly and consistent aesthetic. With it we’d also like to offer you, in a more agile way, functionalities such as Projects.

Projects

Projects are like folders, which can be used to organise pipelines. In the beta version you’ll be able to:

create projects by informing name and description;

change projects name and description;

move pipeline from one project to another;

create pipeline associated to a project;

archive projects that don’t have pipelines.

WHAT YOU MIGHT WANT TO KNOW...

What are beta versions?

The beta versions arise as an opportunity for us to check how the Platform users feel regarding stability, scalability, performance and usability of new layouts and functionalities.

While using the beta versions, you might experience some unexpected situations. The reason for it to happen is that you’re not using the final versions and they remain under improvement. By the test period end, taking into consideration the users feedback, the report of eventual execution errors or the identification of usability issues, we’ll decide to extend the beta versions or to make available the final versions of layouts and functionalities. How can I adhere to the beta versions?

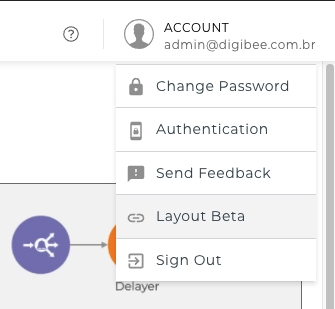

All the Platform users can adhere to the beta versions. When activating the new layout, you automatically make your adhesion and agree with the terms of use. To access the functionalities, activate the Beta Layout in your account:

What are the terms of use of the beta version in the Platform?

To use the beta version, you must:

respect all the terms of use of the operational version;

agree that the use of the Platform beta version implies not being covered by the SLA applied to the active operational version;

agree that the beta version and its functionalities may not be available in a operational version;

not use the regular support channels. Comments, criticism, compliments and suggestions must be registered through the “Send Feedback” channel.

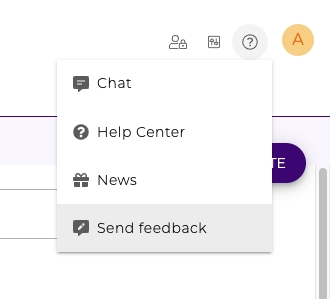

How do I send feedback about a beta version?

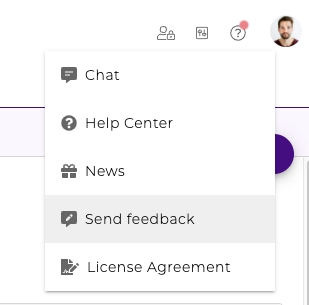

The Platform already has a channel for users to send feedback. Check it out:

You must forward all your suggestions, compliments, complaints and comments through this channel. That way, your feedback is forwarded to the team in charge, which is responsible for making adjustments and improvements.

If you have any other doubts, don’t hesitate to get in touch with your Customer Success Manager.

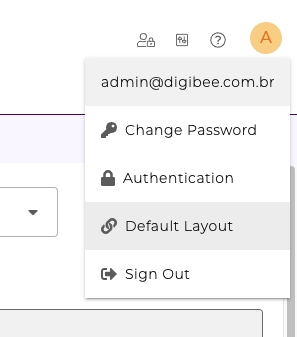

How do I go back to the former layout?

Just access the menu of your profile (illustrated in the example below by the letter A with an orange background) and select the "Default Layout" option:

Release Notes 05-11-2021

We’d like to share some improvements and news:

COMPONENTS

gRPC

We’ve enabled a new component that enables gRPC calls through the Digibee Integration Platform. With it you can execute unary and client stream calls. Read the article about the gRPC component by clicking here.

Stream JSON File Reader

We’ve created a new component that allows large JSON structures enabled in files to be run item by item, with filters and in an efficient way in terms of memory use. Click here to access the article about Stream JSON File Reader.

Log

Fields marked as sensitive in your realm or in the configuration of a pipeline are now obfuscated in the Log component. You can know more about this component by clicking here.

DOCUMENTATION

We’ve updated the reading about a component so you can have a better experience with your integrations.

You can access the new article about:

CAPSULES

To ease your experience when creating new Capsules Collections, we’ve created a guide with the best practices for customization. Click here to access the reading.

RUNTIME

When one of the pipeline replicas was restarted, we would present the term "crash". However, we understand that the term "crash" doesn’t actually represent the occured fact. Therefore, we’re now adopting the term "recycled".

We’ve also fixed a few bug:

Components configuration: we’ve fixed a bug that would allow a mandatory field to be filled with blank spaces only. With that, pipelines and components are correctly documented.

Pipelines configuration: we’ve corrected the error that would stop the InSpec/OutSpec values of a pipeline to be changed.

PUBLIC CAPSULES

Thinking about making your routine with the Digibee Integration Platform easier, we’re releasing ready-to-use Capsules.

Take a look at the Collections with news:

Google Sheets

Get Spreadsheets By Id: consult metadata in your shared sheet.

Get Rows Values by Range: obtain existing data inside the sheet and work with paginated inquiries according to the desired gap.

Append Data: write data in an existing sheet.

Click here to read the complete article about this Capsules Collection.

AND IT’S COMING UP...

gRPC Trigger will allow pipeline exposure according to the gRPC protocol.

Release Notes 04-27-2021

We’d like to share some improvements and news:\

PIPELINE METRICS

We’ve released a functionality that allows you to know what’s going on with your pipeline through these real-time graphics:

Pipeline executions per second (eps)

Pipeline response time (milliseconds)

Pipelines currently running (inflights)

Pipeline message sizes (bytes)

Pipeline memory usage (%)

Pipeline messages in queue (messages)

Pipeline CPU usage (%)

PLATFORM NAVIGATION

For you to get more familiar with terms and concepts related to the Digibee Integration Platform navigation, we’ll release some enlightening articles.

To start, click here and read about Runtime.

COMPONENTS

We’ve updated the LDAP component article. Click here to access it.

COLLECTIONS

Now you can archive Collections that are no longer being used.

FUNCTIONS

We’ve created new functions to optimize your experience with integrations in the Platform. These are they:

String Functions

CONTAINS

Click here to read the article about this and other String Functions.\

JSON Functions

GETELEMENTAT

LASTELEMENT

NEWEMPTYOBJECT

NEWEMPTYARRAY

Click here to read the article about these and other JSON Functions.\

FAIL ON ERROR

We’ve updated the Fail On Error description in some of our components documentation, without changing the behaviour of this configuration parameter. Re-check the following articles:

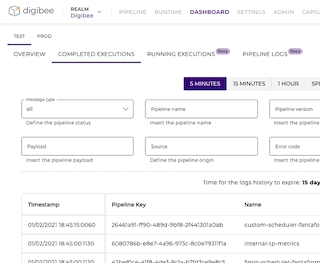

EXECUTIONS RETENTION AND LOGS

We’ve corrected the data retention information in these screens:

dashboard

finished executions

pipeline logs

PUBLIC CAPSULES

Thinking about making your routine with the Digibee Integration Platform easier, we’re releasing ready-to-use Capsules.

Take a look at the Collections with news:

Gupy

Configuring Webhooks: quickly configure and consult the Gupy webhooks.

Upsert Department: manage department registers for existing vacancies at Gupy.

Gupy Business Flow JOB: flow for the creation of vacancies, which groups important steps (job titles, department, branch, template) in a simple way and keeps the safety and errors handling.

Click here to read the complete article about this Collection.

AND IT’S COMING UP...

Soon we’ll be able to manage the Capsules and Collections header images in a specific area. This management can be made even by users that don’t have permission to create a Capsule. With that, there’re no worries regarding the Capsules security.

We’re working to ensure that the Platform will support the use of gRPC protocol in the construction of pipelines.

Release Notes 04-13-2021

We’d like to share some improvements and news

DOCUMENTATION

We’ve updated the reading about a component so you can have a better experience with your integrations.

You can access the new articles about:

LOGS SCREEN

The “Search in the logs screen” article was renamed to “Logs screen” and now brings information about sensitive data and storage limits, including the message size (concept of DGB Truncated). To access the updated reading, click here. We’ve also fixed a bug:

Consumer screen: we’ve normalized the access to the configurations screen when there’s no data in the Realm.

AND IT’S COMING UP...

Navigation layout: soon we’ll have news about the navigation to improve your experience in the Platform.

Projects: you’ll be able to better organize your pipelines, which guarantees a more effective management process.

Pipeline metrics: what about following what’s happening with your pipelines through new graphics in real time?

Release Notes 03-30-2021

We’d like to share some improvements and news:

COMPONENTS

HTML to PDF

The HTML to PDF component now supports the inclusion of protection by password and also the definition of access by permission. That way, it’s possible to generate PDFs with a security layer and with specific access permissions. To read the complete article about the component, click here.

Kafka

We’ve added new configurations to the Kafka component, enabling the header values to be sent to the Kafka broker with the selected charset application. Besides, the header value of a message can be interpreted in binary format (base64). Click here to access the updated article about the component.

Log

We’ve implemented an improvement in the Log component and, from now on, you don’t have to use functions to remove the line break characters in its use. Read the updated article about his component by clicking here.

TRIGGERS

Kafka

We’ve added a resource that can be activated to enable one or more headers to be received in messages consumed by the Kafka broker. Click here to read the article about Kafka trigger.

FUNCTIONS

To enhance your reading experience, we’ve improved the examples in the “Double Braces - String Functions” article, more specifically in the INDEXOF and LASTINDEXOF functions. Click here to access the article.

DOCUMENTATION

We’ve updated the reading about a component so you can have a better experience with your integrations.

Access the new Scheduler Trigger article by clicking here.\

We’ve also fixed a bug:

DB components: we’ve solved a problem that wouldn’t allow the use of databases with OLAP-type bases.

Release Notes 03-16-2021

We’d like to share some improvements and news:

COMPONENTS

SSH Remote Command

We’ve delivered a new component that allows the execution of commands in a server that supports remote SSH. To know more about SSH Remote Command, click here.\

Kafka

We’ve added the resource of adding one or more headers in the message to be sent to the Kafka broker. Click here to read the complete and updated article about the component.\

DOCUMENTATION

We’ve updated the reading about some components so you could have a better experience with your integrations.

You can access the new articles about:

FEEDBACK

We’d like to know your comments and improvement suggestions to the Platform. That’s why we invite you to use the new resource for sharing opinions. See how easy it is for you to send your feedback:

We’ve also fixed a few bugs:

Stream DB V3: we’ve corrected a failure in the connection pool that, after a timeout execution with error, wouldn’t let the connections to be returned to the pool. Besides, we’ve eliminated the problem that would cause the incorrect interpretation of duplicated Double Braces expressions in Stream DB V3.

Do While e Parallel Execution: we’ve fixed the bug that would create inconsistency in the Do While and Parallel Execution componentes when pipelines Major versions were created.

Configurations screen: we’ve solved a proportion issue in the Consumer, Global, Relation and Multi instance screens, that would interfere in the form visualization.

Standard error screen: formerly, non-treated errors would generate a white screen. Now a screen with the standard errors exhibition is displayed.

Release Notes 03-02-2020

We’d like to share some improvements and news

FUNCTIONS

We’ve added the DIFFDATE function to the Platform. Now you can calculate the difference of years, months, days, hours, minutes, seconds and milliseconds between two dates. Click here to access our complete article about this and other Date Functions.

DOCUMENTATION

We’ve updated the reading about some components so you could have a better experience with your integrations.

You can access the new articles about:

PIPELINE LOGS SCREEN

Now you have a better view of the logs related to the pipelines deployment steps. With that, you can check the status of the deployment and the error messages that weren’t displayed.

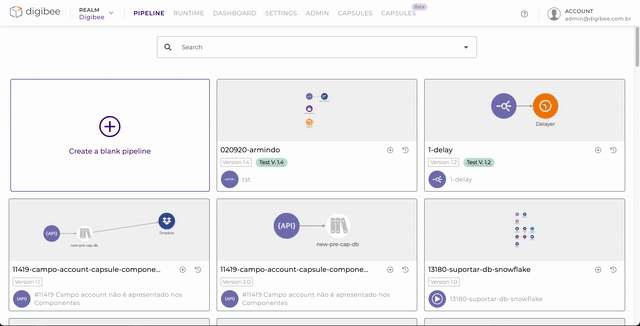

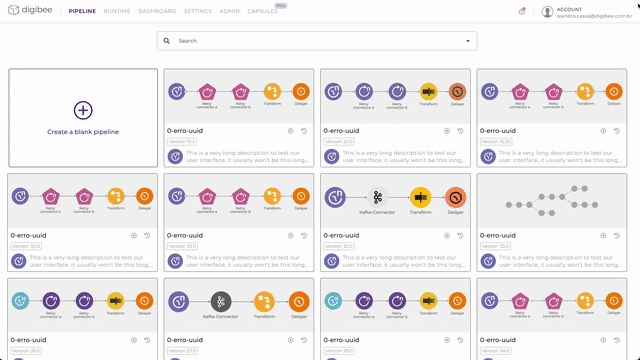

PIPELINES LISTING SCREEN

We’ve redesigned the pipelines listing display so you could have the most out of the screen. Besides, we’ve made the screen more responsive, adapting it to different resolutions.

FEEDBACK

We’ve created an exclusive channel for you to share your opinion about the Platform, being able to send general comments and improvement suggestions. This resource is present in each one of our screens, which let us know where your opinion comes from. See how to send us your feedback:

We’ve also fixed a few bugs:

JSON to CSV V2: we’ve corrected a problem that would display an error message of the DB V2 component, when the actual error would happen in the execution of the JSON to CSV V2 component.

Stream DB V3: the stream components (Streamers DB and File Reader) now end the resources in the proper way after their executions are done instead of ending them only after the pipeline execution.

Append File: we’ve adjusted the "Files To Append" list to support Double Braces in the field where the name of the file is informed.

Zip File: we’ve adjusted the "Files" list to support Double Braces in the field where the name of the file is informed.

Email Trigger V2: we’ve fixed an error that would allow operations made in messages received by the Email V2 trigger not to be properly moved, marked as read or deleted, because the mailbox has already been disconnected.

Pipeline with multi-instance: we’ve eliminated the bug that would allow the deployment of a pipeline with conflicting name between multi-instance and no-multi-instance pipelines. For example: the "store-newyork" pipeline whose name is "store" and instance is "newyork" could have a conflict with a previously deployed with the name "store-newyork". Even though they’re different pipelines, the names match and this is not allowed.

Release Notes 02-16-2021

We’d like to share some improvements and news:

COMPONENTS

Base64

We’ve created a component that enables a file or text to be transformed to the Base64 format, generating as output a new text or a new file according to your need. To read the article about Base64, click here.

Append File

We’ve delivered a new component that allows you to add the content of a file to another existing file. Click here to read the article about Append File.

SOAP V2

We’ve added a new functionality to the SOAP V2 component so you can specify that the request body will be provided by a file. Click here to read our updated article about SOAP V2.

DB V2

Now it’s possible to define the DB V2 connection pool size as a number equivalent to the amount of consumers configured during the implantation. Besides, you can define that the pool is exclusive from the component.

JMS

Now we support IBM MQ, a new broker of the JMS component. Click here to read the updated article.

TRIGGERS

HTTP Trigger

We’ve updated the reading about HTTP Trigger so you can have a better experience with your integrations. Click here to access the article.

JMS Trigger

Now we support IBM MQ, a new broker of the JMS Trigger. Click here to read the updated article.

DATABASES

We’ve ratified the Snowflake database in the Platform. Click here to know which other databases are supported.

EXCEEDED EXECUTION TIME

We’ve improved the message that informs about the progress of the executions that exceed the maximum waiting time if the test-mode in the pipeline canvas screen. Besides, now we inform that these executions can be consulted in the Dashboard, inside “Finished executions”

USABILITY IMPROVEMENTS

Now, when clicking on the “Pack to pipelines” link or on the Digibee logo, you can use the following modifiers to open a new tab, keeping the pipeline canvas open:

Windows / Linux: CTRL + left button of the mouse

Mac: COMMAND + left button of the mouse

SECURITY

We’ve changed the way the password is recovered, where a change link is sent with the instructions email.

We’ve enhanced the RECAPTCHA mechanism sensitivity, decreasing the false positive cases.

We’ve also fixed a bug:

Runtime: we’ve made an adjustment in the Runtime screen, where the deployed pipelines list wasn't being displayed when the number of licenses was exceeded in a new deployment.\

Release Notes 02-02-2021

We’d like to share some improvements and news:

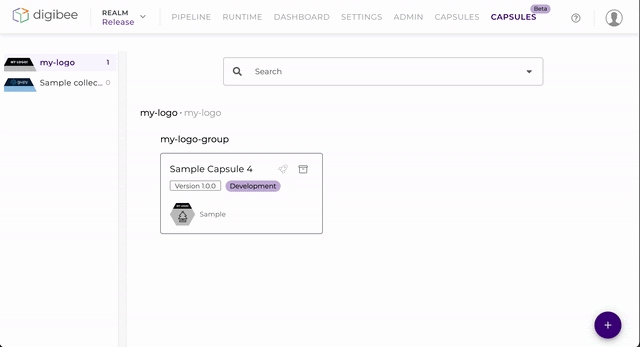

DIGIBEE CAPSULES

We’ve released the Digibee Capsules! Capsules are reusable components that can be adopted by any Platform user, applying the same visual development model conceived in the pipeline creation.

A Capsule allows the flow integration to be published in the components palette to be used in another moment, in an even simpler and quicker way.

Click here to know more details about the Capsules in our webpage.

Click here to access our Start guide for the use of Capsules.

COMPONENTS

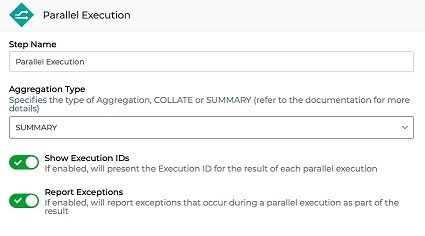

Parallel Execution

We’ve added the following capacities to the component:

definition of the execution lines result (for example, a summarized output of the total of executions or the details of all the executions);

exhibition of the results based on the name of the execution lines;

optional hiding of the errors.

To read the updated article about Parallel Execution, click here.

Google Drive

We’ve added the “Mime Type” field to the Google Drive component, enabling determined files to be converted into some Google Workspace file type in the upload moment. To read the complete article about this component, click here.

Zip File

The Zip File component now decompresses zip files, besides compressing multiple files into a single zip.

FUNCTIONS

We’ve added the TOBOOLEAN utilities function to the Platform. To know more about this and other functions, click here.

USABILITY IMPROVEMENTS

We’re always working to improve your experience in our Platform. Check what we’ve done:

we’ve added a message receival indication in the new Help icon;

we’ve inserted the option to search all the message types in the search filter in the screen of concluded executions and pipelines logs;

now the time format in the Runtime screen follows the standard of the other Platform screens (24h).

We’ve also fixed a few bugs:

Error message on Canvas: we’ve improved the error message quality in the test-mode when a test was made in the pipeline making reference to a non-existing account or globals.

SAP: we’ve eliminated the error that wouldn’t let the test-mode to correctly respond when the SAP administrator made a change in the RFC. For deployed pipelines, the redeployment is still necessary.

Release Notes 01-19-2021

We’d like to share some improvements and news:

COMPONENTS

DB

The component now supports Oracle Netsuite ERP. This new database only allows inquiries to the base and it’s not possible to perform INSERT, UPDATE and DELETE operations. To know which other databases are supported by the Platform, click here.

SUPPORT

The help menu inside the pipeline canvas is more complete. On top of having a way to start a conversation with our support team, you also can:

access the help center and search about anything related to the Platform;

check the list of our most recent news, in case you’ve missed your communications;

click on the icon to the keyboard shortcut, which used to be at your page top.

We’ve also fixed a bug:

SAP: when a call with an invalid payload to a RFC was made, an inconsistency in the SAP component used to affect the functioning of the other calls. Now, even if this error occurs, the pipeline works normally for the correct calls. If you use this component in your pipelines, redeploy them for the correction to be applied.

Release Notes 01-05-2021

We’d like to share some improvements and news:\

COMPONENTS

JSON Transformer

We’ve created a new component so you can transform your JSONs in a quicker and more efficient way, without using codes. To know more about JSON Transformer, click here.

Parallel Execution

We’ve delivered a new component that allows you to create parallel execution flows. Click here to read the article.\

TRIGGERS

We’ve added to the REST and HTTP triggers a new parameter that allows you to define the maximum size of the payload sent in a request. The configuration values are:

1MB

2MB

3MB

4MB

5MB

The current limit value used in all the pipelines is 5MB.

We’ve also fixed a bug:

Multi-instance: the Platform would incorrectly allow the registration of fields with numerical values only, making them unusable due to the lack of support for names composed only by numbers. Therefore, a rule has been created to prevent the creation of invalid fields.

Was this helpful?